Agentes de IA trazem eficiência, mas também dilemas éticos e de privacidade. Empresas precisam equilibrar inovação com governança e responsabilidade para garantir confiança.

Home » Privacidade e Ética no Uso de Agentes de IA: Um Desafio Urgente para Empresas

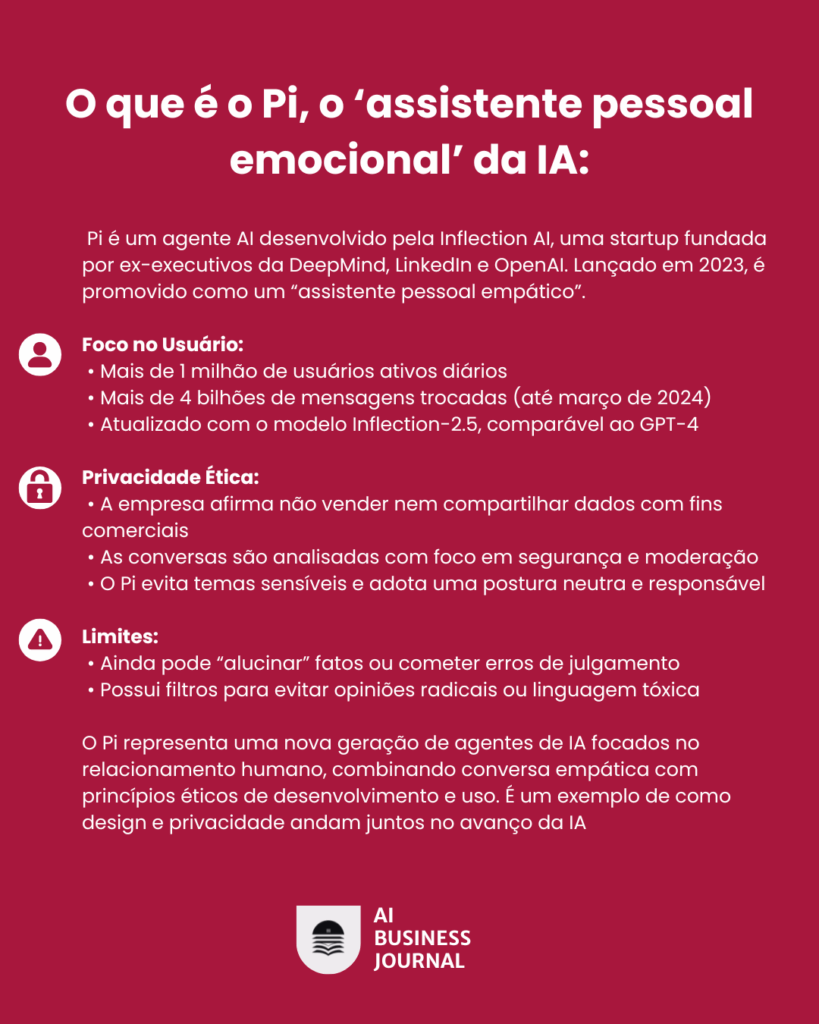

Agentes de inteligência artificial são sistemas autônomos que podem realizar tarefas em nome de um ser humano ou outro sistema de software. Embora possuam recursos de grandes modelos de linguagem (LLM) como processamento de linguagem natural, esses agentes também podem tomar decisões, executar ações, resolver problemas, interagir com ambientes externos. Podemos citar como exemplos o Devin para escrever e executar códigos e o PI voltado para conversação e suporte emocional.

Para os agentes realizarem suas atividades, é necessário coletar e processar grandes volumes de dados pessoais para melhorar e oferecer uma experiência cada vez mais personalizada e nesse contexto surgem alguns dilemas.

Dilemas éticos e de privacidade do uso de IA

Um dos dilemas na adoção do uso de IA por clientes e empresas é o fato de lidar com escolha entre o desejo de simplificar atividades versus a necessidade de proteger os dados pessoais. Para isso basta observar a quantidade de informações pessoais e sensíveis que compartilhamos com assistentes de IA como o Pi diariamente. No caso do ChatGPT, apesar de não existir um número oficial de dados trocados com o agente, estatísticas mostram que o ChatGPT é responsável por cerca de 10 milhões de consultas diárias, com sessões durando em média 13 minutos e 35 segundos. Considerando que um usuário típico digita entre 150 e 300 palavras por sessão, isso corresponde a 1 kB a 2 kB de texto – sem contar metadados, contexto de histórico, localização etc.

Notícias recentes mostram casos de violação e risco de privacidade:

“Em julho de 2024, a Meta interrompeu o uso de IA generativa no Brasil após advertência da ANPD (Autoridade Nacional de Proteção de Dados) que identificou risco grave ao direito a privacidade por coleta de dados pessoais sem consentimento claro”

“A Reuters noticiou em abril de 2025 que agentes de IA autônomos apresentam riscos de violação de privacidade, infrações legais e saídas enviesadas ou falsas. Destaca-se a necessidade de governança robusta e auditoria contínua”

Embora muitas das questões éticas originadas pelos agentes estejam relacionadas a comportamentos inadequados, outras preocupações éticas surgem mesmo quando a tecnologia de IA autônoma funciona conforme o esperado. Isso pode ocorrer, pois funcionários podem sofrer consequências psicológicas.

Varshney explica que, se os trabalhadores perceberem que os agentes de IA executam melhor suas funções, isso pode afetar sua autoestima. “Se você estiver em uma posição em que todo seu conhecimento parece inútil, como se estivesse subordinado ao agente de IA, você pode perder sua dignidade”, afirma. Em alguns debates sobre ética da IA, essa perda de dignidade é vista como uma violação dos direitos humanos.

Além disso, estudos recentes mostram que assistentes de IA variam enormemente na coleta de dados: enquanto o ChatGPT se limita a cerca de 10 tipos de informação, o Gemini coleta cerca de 13, e o Meta AI chega a 32 — incluindo dados biométricos, orientação sexual e religião, além de armazenar todo o histórico por padrão, em muitos casos sem opção para exclusão completa.

Neste contexto surge a seguinte questão: Quando falamos de agentes tomando decisões como garantir que a decisão será baseada em princípios éticos e de privacidade?

O papel das empresas para obterem uma IA Confiável

Podemos dizer que uma IA Confiável é aquela que reúne atributos como justiça, explicabilidade, robustez, segurança, privacidade e responsabilidade.

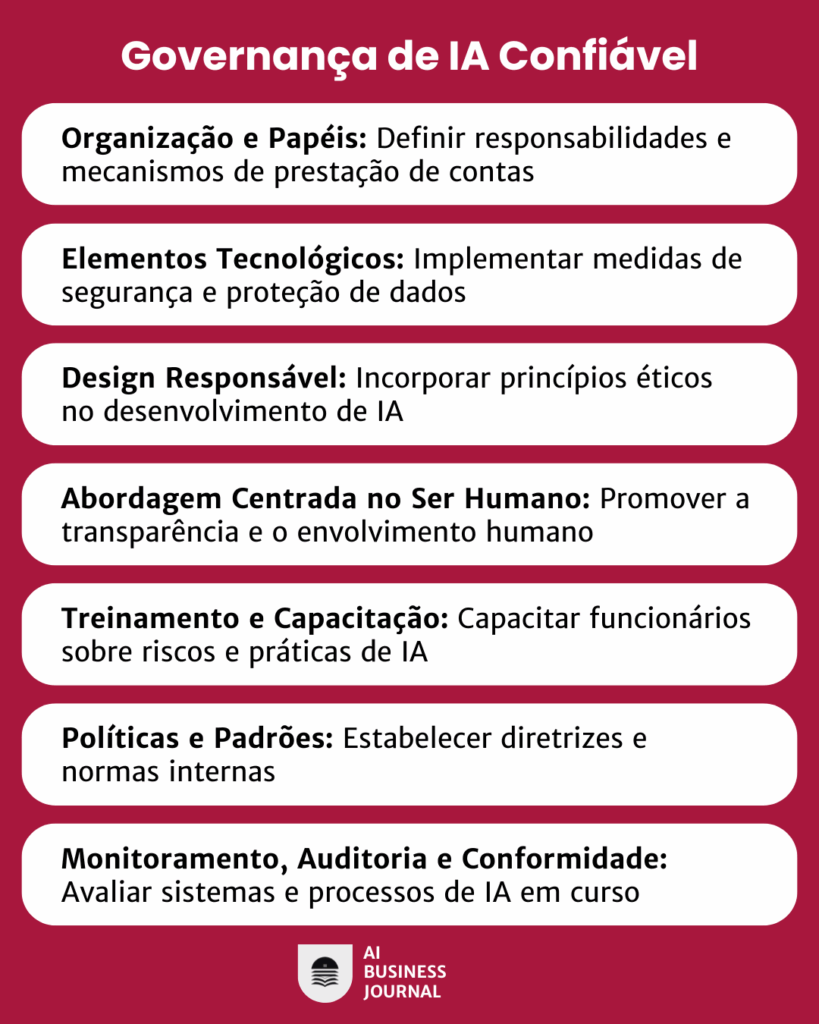

Com base em boas práticas de mercado e nos principais frameworks internacionais (como OECD, ISO/IEC 42001 e o AI Act Europeu), podemos agrupar as medidas adotadas pelas empresas em sete grandes categorias que estruturam um modelo de governança de IA confiável:

- Organização e papéis

- Elementos Tecnológicos

- Design Responsável

- Abordagem centrada no ser humano

- Treinamento e capacitação

- Políticas e Padrões

- Monitoramento, auditoria e conformidade

Esses itens sugerem um modelo de framework de governança IA como no exemplo a seguir, tratando processos, padrões e proteções que ajudam a garantir que os sistemas e ferramentas de inteligência artificial sejam seguros e éticos.

- Organização e papéis: Inclui a criação de comitês de ética e limitação da autonomia dos agentes. Empresas como Google, Microsoft, Meta e Salesforce criaram comitês internos de ética em IA para avaliar impactos dos sistemas antes de serem lançados, rever decisões automatizadas com potenciais consequências negativas, criação de códigos de conduta para IA.

- Elementos tecnológicos: Treinamento de modelos com filtros e curadoria ética; empresas como OpenAI, Anthropic e Cohere estão aplicando RLHF (Reinforcement Learning from Human feedback) para ensinar os modelos a evitar conteúdo nocivo enviesado ou antiético.

- Design responsável: mecanismos de proteção embutidos desde o início do projeto e inclui minimização de dados, anonimização e pseudoanonimização e restrições de acesso

- Abordagem Centrada no ser Humano: desenvolver soluções para beneficiar as pessoas, respeitando sua dignidade, seus direitos e sua autonomia, permitindo que o ser humano possa corrigir ou parar a IA.

- Treinamento e Capacitação: consiste em Formação contínua de colaboradores para promover uso responsável, ética digital, pensamento crítico e accountability no uso da IA.

O debate da privacidade e ética no uso de agentes de IA não é apenas técnico, é essencialmente social. Estamos diante de uma tecnologia capaz de transformar indústrias inteiras, mas também de reforçar desigualdades e ameaçar liberdades, caso mal direcionada.

O protagonismo no mundo de inteligência artificial será cada vez mais de empresas e profissionais que conseguirem aliar inovação com responsabilidade. A confiança será seu maior ativo. É preciso que líderes, desenvolvedores e sociedade atuem juntos para garantir que os agentes de IA sejam forças de inclusão, respeito e transparência.

Referências Bibliográficas:

Novos riscos éticos cortesia de agentes de IA? Pesquisadores estão no caso: https://www.ibm.com/br-pt/think/insights/ai-agent-ethics

OECD. AI Glossary: https://oecd.ai/en/terms

Tecnoblog. Quais são os tipos de inteligência artificial: https://tecnoblog.net/responde/quais-sao-os-tipos-de-inteligencia-artificial

Lifewire. The Four Types of Artificial Intelligence: https://www.lifewire.com/four-types-of-artificial-intelligence-5112620

European Commission. Ethics Guidelines for Trustworthy AI: https://digital-strategy.ec.europa.eu/en/library/ethics-guidelines-trustworthy-ai

OECD AI Principles. Disponível em: https://oecd.ai/en/ai-principles

IBM. What is Trustworthy AI?: https://www.ibm.com/think/topics/trustworthy-ai

Atlan. McKinsey Data Governance Framework: https://atlan.com/mckinsey-data-governance-framework

Axios. Pi AI surpasses 6 million users: https://www.axios.com/2024/03/07/inflection-ai-chatgpt-openai-comparison

Wired. Why AI Assistants Are Getting More Emotional: https://www.wired.com/story/fast-forward-chatgpt-rivals-emotions

Inflection AI. Privacy Policy (Pi). Disponível em: https://inflection.ai/privacy-policy

Cognition Labs. Introducing Devin: the first AI software engineer: https://www.cognition-labs.com/blog/devin

Reuters. Musk’s Grok expanding in US government raises conflict concerns: https://www.reuters.com

The Hacker News. Meta Suspends AI Launch in Brazil After Privacy Warning: https://thehackernews.com/2024/07/meta-halts-ai-use-in-brazil-following.html

TechCrunch. Signal president warns of agentic AI privacy threats: https://techcrunch.com

A Risk Manager Framework: https://www.nist.gov/itl/ai-risk-management-framework

McKinsey’s Data Governance Framework: 4 Pillars & 5 Steps to Implement it:

https://atlan.com/mckinsey-data-governance-framework

MIT Sloan: https://sloanreview.mit.edu/article/the-responsible-ai-maturity-model

ISO 26303:2022: https://www.iso.org/standard/81229.html

Mauricio Manzueto é Diretor de Tecnologia da Informação do BTG Pactual e possui mais de 20 anos de experiencia em cargos de liderança em empresas de consultoria e em empresas do mercado financeiro. É professor de disciplinas de MBA relacionadas a estratégia e gerenciamento de projetos. Atualmente cursa o MBA de Inteligência Artificial e Analytics para Negócios da FGV e tem interesse em pesquisas sobre Ética e Privacidade no uso de IA, Liderança e no estudo de modelos de aprendizado de máquina para Mercado Financeiro.

O futuro acontece aqui: esteja entre os primeiros a receber insights, tendências e oportunidades que moldam o mercado.