Agentes autônomos prometem eficiência com IA, mas criam novos vetores de ataque invisíveis. Sem guardrails e auditoria, decisões críticas podem sair do controle — com alto risco operacional.

Home » De Aliados a Ameaças: Como Agentes Autônomos Estão Reescrevendo a Segurança Digital

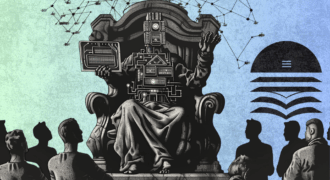

A automação inteligente está deixando de ser um diferencial competitivo e se tornando padrão em operações corporativas. Agentes autônomos alimentados por inteligência artificial, capazes de tomar decisões em tempo real, já são utilizados para atendimento ao cliente, análise de fraudes, priorização de incidentes de segurança, gestão de infraestrutura e até remediação de alertas em SOCs. A promessa é clara: escala, eficiência e economia. Mas junto a ela, cresce um novo vetor de risco silencioso, pouco monitorado e altamente explorável. A pergunta que poucos estão fazendo: estamos prontos para confiar decisões críticas a máquinas?

A Era dos Agentes Autônomos

Nos últimos dois anos, houve uma explosão na adoção de agentes autônomos, sistemas baseados em LLMs (como GPT-4, Claude e LLaMA) que interagem com APIs, bancos de dados e serviços para executar tarefas de forma contínua. Ferramentas como AutoGPT, LangChain Agents, CrewAI e HuggingGPT têm sido adaptadas por empresas para orquestrar fluxos complexos, como agendamento dinâmico de reuniões, triagem jurídica, análise de contratos e gerenciamento de pipelines de DevOps.

Esse avanço não se restringe a aplicações leves. Em ambientes de segurança, já é comum ver agentes aplicando correções automáticas de configuração em firewalls, reclassificando tickets de alerta ou isolando endpoints comprometidos, tudo com pouca ou nenhuma supervisão humana. Isso marca uma virada: a IA não está apenas sugerindo ações. Ela está agindo.

Automação sem Fricção, mas com Falhas

Esse novo paradigma tem um efeito colateral direto: o crescimento invisível da superfície de ataque. Tradicionalmente, automações eram baseadas em regras fixas, controladas e auditáveis. Agora, sistemas baseados em IA operam com base em inferências, muitas vezes opacas e não determinísticas. Isso abre espaço para falhas inesperadas e para vetores de ataque que ainda não conhecemos totalmente.

Um exemplo notório foi a exposição de dados confidenciais via GitHub Copilot. Desenvolvedores passaram a confiar cegamente nas sugestões do modelo, inserindo trechos de código com hardcoded credentials e práticas inseguras sem revisão. O mesmo ocorre com agentes autônomos que tomam decisões sobre infraestrutura: ao lidar com um falso positivo, um agente pode acidentalmente derrubar um serviço legítimo ou pior, reconfigurar permissões de forma insegura.

Casos Reais de Uso (e Abuso)

– Help Desk e Engenharia Social Automatizada: houve casos documentados onde LLMs em ambientes de atendimento foram explorados com prompt injection para liberar dados de clientes ou executar ações não previstas (ex: reset de senha). Um atacante com domínio sobre o funcionamento de agentes pode induzi-los a agir de forma nociva usando apenas linguagem natural.

– DevOps e CI/CD: em pipelines com integração contínua controlada por agentes (como em CrewAI), há risco direto de execução de comandos perigosos. Se o modelo for manipulado, ele pode aceitar código malicioso em um pull request e promovê-lo automaticamente ao ambiente de produção.

– Resposta a Incidentes: alguns SOCs já usam agentes para priorizar alertas com base em contexto e sugestão de resposta. Um ataque sofisticado pode explorar esse mecanismo para camuflar um comportamento anômalo ou gerar ruído que distraia o time de uma ameaça real.

O Que Vi na Prática

Atuando como líder técnico em operações de segurança (SOC) e DevSecOps, já vi esse dilema surgir mais de uma vez. Em um caso real, um cliente adotou automação com agentes integrados ao Cortex XDR para aplicar respostas automáticas a incidentes. Após uma sequência de falsos positivos, o agente isolou máquinas legítimas de produção por inferir, erroneamente, que comportamentos normais eram maliciosos. O impacto foi imediato: interrupção de serviço, retrabalho e desconfiança generalizada na automação.

Em outro cenário, em ambiente regulado, investigamos um incidente onde um pipeline de CI/CD gerenciado por IA havia aceitado uma alteração maliciosa em um script de provisionamento. A inteligência artificial classificou o risco como baixo e liberou a execução, mas os logs mostraram claramente que houve manipulação no prompt inicial. Isso só foi descoberto após auditoria manual.

A Nova Superfície de Ataque

Do ponto de vista da segurança cibernética, a adoção de agentes autônomos redefine o que consideramos superfície de ataque. Agora, não são apenas endpoints, redes ou aplicações que estão sob risco, mas também: as prompts e instruções internas dadas à IA; as APIs que os agentes acessam; o contexto de execução e as permissões atribuídas a esses agentes; a falta de logs estruturados e auditáveis de suas decisões.

Além disso, agentes mal configurados podem agir como “insiders automatizados”: têm acesso privilegiado, tomam decisões rápidas e são difíceis de monitorar. Um adversário que conseguir comprometer o fluxo de decisão de um agente pode causar danos sistêmicos sem nunca acionar uma regra de detecção tradicional.

O Dilema da Confiança Cega

Esse cenário coloca executivos, CISOs e arquitetos de segurança frente a um dilema: como equilibrar os ganhos operacionais da automação com os riscos de agentes que atuam fora do radar? Muitas empresas estão adotando soluções de forma acelerada, pressionadas por KPIs de eficiência, mas sem envolver os times de segurança na arquitetura desses agentes.

Além disso, há uma percepção equivocada de que o simples uso de ferramentas de IA renomadas garante segurança. Mas modelos LLM não têm senso de contexto corporativo nem capacidade nativa de diferenciar dados sensíveis, decisões críticas ou ambientes de risco.

Uma mínima arquitetura de contenção

Estabeleça diretrizes específicas para agentes autônomos – escopo, permissões, reversibilidade. Implemente guardrails estruturais e semânticos – validação, chaining seguro, revisão humana. Adote princípios de Zero Trust para agentes – mínimo privilégio, tokens temporários, monitoramento. Mantenha trilhas de auditoria legíveis – registre decisões, inputs, motivos e impactos. Execute simulações adversariais – red teaming, prompt injection, exploração controlada.

Referências

- Copilot sugerindo códigos inseguros com hardcoded credentials (GitGuardian): https://blog.gitguardian.com/yes-github-copilot-can-leak-secrets/?utm_source=chatgpt.com

- Casos práticos de vazamentos e más práticas com IA generativa (GitGuardian): https://blog.gitguardian.com/github-copilot-security-and-privacy/?utm_source=chatgpt.com

- Copilot mostrou código privado a outros usuários — relato real: https://medium.com/@jankammerath/copilot-leaks-code-i-should-not-have-seen-e4bda9b33ba6?utm_source=chatgpt.com

- SecureCodeWarrior — explicando riscos de prompt injection em ferramentas como LangChain e agents: https://www.securecodewarrior.com/article/prompt-injection-and-the-security-risks-of-agentic-coding-tools?utm_source=chatgpt.com

- IBM — riscos e prevenção de prompt injection em LLMs operacionais: https://www.ibm.com/think/insights/prevent-prompt-injection?utm_source=chatgpt.com

- Snyk Labs — ataques a fluxos de agentes via manipulação de prompt (Agent Hijacking): https://labs.snyk.io/resources/agent-hijacking/?utm_source=chatgpt.com

- CTech / Calcalist — bug no Copilot expôs repositórios de empresas como Microsoft e Google: https://www.calcalistech.com/ctechnews/article/hjuo8f25kl?utm_source=chatgpt.com

- Unit42 (Palo Alto) — estudo sobre ameaças emergentes em agentes de IA: https://unit42.paloaltonetworks.com/agentic-ai-threats/?utm_source=chatgpt.com

- Reuters — agentes com IA geram riscos ampliados de compliance, privacidade e segurança: https://www.reuters.com/legal/legalindustry/ai-agents-greater-capabilities-enhanced-risks-2025-04-22/?utm_source=chatgpt.com

- Design Patterns for Securing LLM Agents — melhores práticas para mitigar riscos: https://arxiv.org/abs/2506.08837?utm_source=chatgpt.com

- Breaking ReAct Agents — explorando como quebrar lógica de raciocínio de agentes LLM: https://arxiv.org/abs/2410.16950?utm_source=chatgpt.com

- LlamaFirewall — framework open-source para proteger agentes autônomos: https://arxiv.org/abs/2505.03574?utm_source=chatgpt.com

- Wired — “Here Come the AI Worms”: o Morris II e a replicação via prompt: https://www.wired.com/story/here-come-the-ai-worms/?utm_source=chatgpt.comWired — ataque “Imprompter” extraiu dados pessoais com 80% de sucesso: https://www.wired.com/story/ai-imprompter-malware-llm/?utm_source=chatgpt.com

Henrique Campos tem mais de 20 anos de vivência corporativa passou por diversas gigantes multinacionais de vários segmentos como Aeroespacial, Farma, Financeiro e Industria, liderando projetos de Inovação, Hiperconectividade, Blockchain, Tokenização e Cyber Security. Mentor e Conselheiro de Startups e empresas de tecnologias disruptivas. PalestranteTedX. Hacker Ético e PhD em Ciência da Computação pela UNICAMP

O futuro acontece aqui: esteja entre os primeiros a receber insights, tendências e oportunidades que moldam o mercado.